Episode 2 / Azure Data Factory

Présentation du service

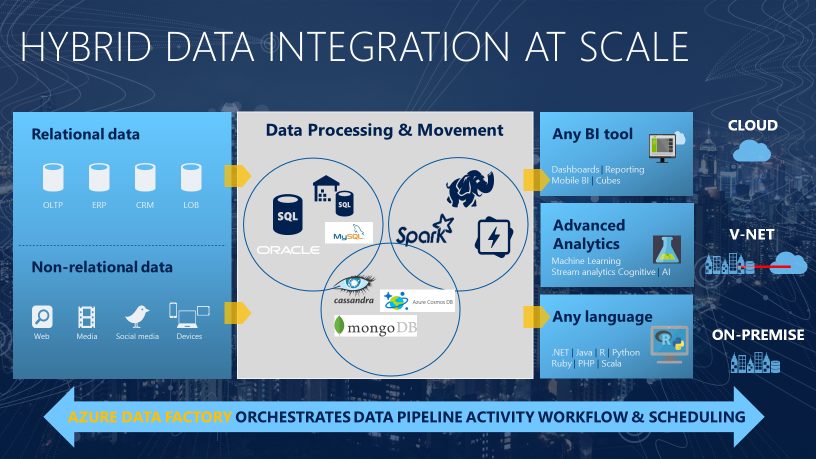

Azure Data Factory est le service cloud pour la gestion de flux de données structurées ou non. Ce service entièrement géré sur Azure permet de créer des projets de toute envergure de type ETL ou ELT.

Pas moins de 80 connecteurs préconfigurés sont disponibles pour récupérer vos données. Bien sûr on retrouve les bases de données classiques comme SQL Server, Oracle, MySQL, Amazon Redshift, Vertica, Teradata … mais également des sources de données de type fichiers sur Amazon S3, FTP, HDFS … Pour avoir plus de détails sur les connecteurs disponibles, je vous invite à consulter ces liens page Supported Data Stores And Format

.

Azure Data Factory permet également d’exécuter des flux SSIS et ainsi de s’affranchir d’une installation « On Premise » d’un server SSIS.

En quelques clics Azure Data Factory permet de mettre en production des flux de données sans aucunes lignes de codes et sans gérer une infrastructure de servers. ADF vous permet de déplacer vos données « On Premise » vers le cloud et ainsi bénéficier de toute la puissance que peut offrir une architecture cloud.

Un peu de vocabulaire

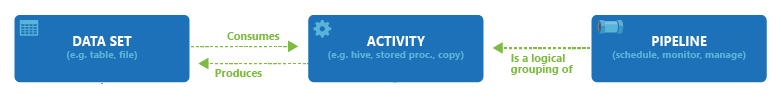

Data Set : source de données utilisées dans les flux (source ou destination).

Activité : une activité représente une action à effectuer sur les données. Par exemple la copie de fichiers, ou encore la transformation de données.

Pipeline : une fabrique de données peut avoir un ou plusieurs pipelines. Un pipeline est un regroupement d’activités qui exécutent une tâche.

ETL: Extract, Transform and Load. Ce processus récupère les données sources, les transforme avant de les charger dans un environnement cible.

ELT : Extract, Load and Transform. Ce processus a pour objectif de récupérer les données provenant de plusieurs sources de données pour les déplacer à un endroit en vue de leur transformation.

La différence entre l’ETL et l’ELT est le moment et l’endroit où la transformation des données est effectuée.

Cas d’usage

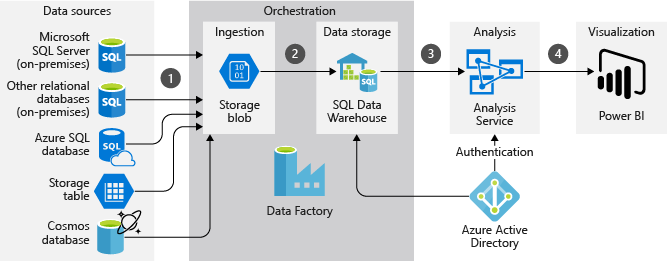

Voici un exemple de cas d’usage d’Azure Data Factory qui inclut différentes sources de données « On Premise » ou cloud, structurées ou non.

Pour chaque source de données, des mises à jour sont exportées régulièrement dans une zone de transit du stockage d’objets blob Azure.

Data Factory charge de façon incrémentielle les données provenant du stockage d’objets blob dans des tables de mise en lots de SQL Data Warehouse. Les données sont nettoyées et transformées pendant ce processus. La technologie PolyBase peut paralléliser le processus pour des jeux de données volumineux.

À l’issue du chargement d’un nouveau lot de données dans l’entrepôt, un modèle tabulaire Analysis Services créé précédemment est actualisé. Ce modèle sémantique simplifie l’analyse des données d’entreprise et des relations.

Les analystes d’entreprise utilisent Microsoft Power BI pour analyser les données en entrepôt via le modèle sémantique Analysis Services.

Source : https://docs.microsoft.com/fr-fr/azure/architecture/example-scenario/data/data-warehouse

Tarification

La facturation de Azure Data Factory est basée sur deux principes :

L’orchestration

Le nombre d’exécutions d’activités => 0,844 € / 1000 exécutions

Utilisation du runtime auto-hébergé => 1,265 € / 1000 exécutions

L’exécution

Il s’agit de l’infrastructure de calcul utilisée par ADF pour l’intégration de données entre différents environnements réseau.

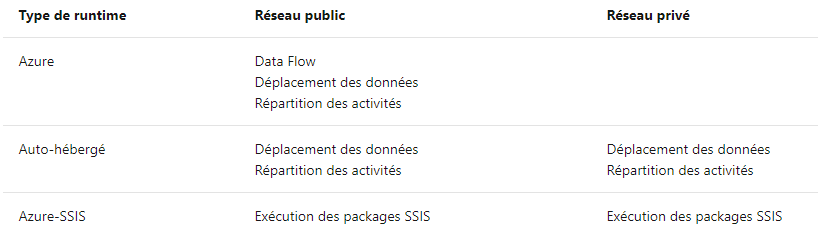

Data Factory propose trois types de runtime d’intégration :

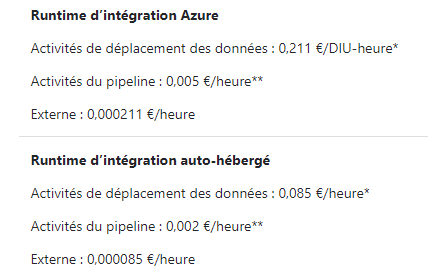

Des tarifs spécifiques s’appliquent en fonction du runtime :

Le runtime Azure SSIS est utilisé dans le cas d’exécution de package SSIS. Pour ce service la tarification se fait à l’heure et est en fonction de la configuration de l’instance choisie.

A titre d’exemple, pour une instance de type 4 cœurs, 8 Go de RAM et 40 Go de disques, Microsoft nous facture 0,7081€/heure. Donc pour une utilisation de 3h/jours, le tarif est d’environ 65€/mois.

Ce service peut être démarré ou arrêté à la demande. A noter qu’il est possible de planifier le démarrage du runtime via des script PowerShell ou directement dans un pipeline de Data Factory.

https://docs.microsoft.com/fr-fr/azure/data-factory/how-to-schedule-azure-ssis-integration-runtime

D’autres coûts liés à l’exécution des Data Flow, au debugging ou encore au monitoring et à la surveillance peuvent s’appliquer.

Pour en savoir plus :

https://azure.microsoft.com/fr-fr/pricing/details/data-factory/data-pipeline/

Pour aller plus loin :

https://docs.microsoft.com/fr-fr/azure/data-factory/